该公司的首席人工智能科学家,现代先驱之一Yann LeCun表示,该公司的目标包括充满“常识”(common sense)的数字助理,能与人进行任何主题的交谈,这将会是是当今语音控制设备的重要一步。

他还希望使AI成为控制其社交网络的一个更实用的工具,例如实时监控视频并帮助其人类主持人的军队决定,那些服务内容是被允许的。

LeCun先生最近在接受英国“金融时报”采访时表示,Facebook希望与多家芯片公司合作开发新设计 ,他们最近也宣布与英特尔合作开展项目。但他也表示,Facebook也在开发自己的定制“ASIC”芯片,以支持它的AI程序。

“众所周知,Facebook会在需要时构建其硬件,包括构建自己的ASIC。如果有任何不解之处,我们将继续努力”,Lecun说,这也是Facebook官方第一次公开其在芯片领域的野心。

谈到公司有可能在芯片哪些方面取得突破的时候,LeCun强调,在底层会有很大的空间。

Facebook决定打造自己的芯片,对Nvidia来说,又将是另一个长期挑战。后者是目前用于数据中心AI的图形处理器的主要生产商,在各大厂商进入芯片领域之后,Nvidia面临着大型数据中心客户退出的短期挤压。

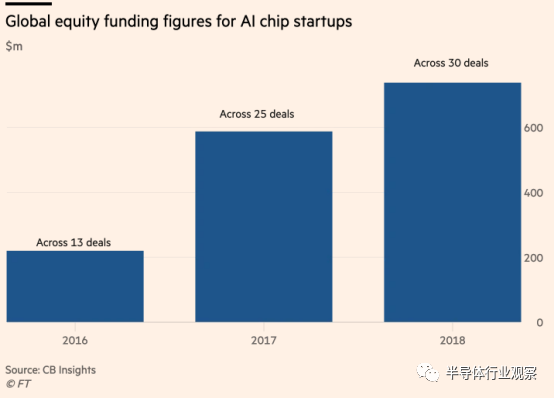

随着对以闪电般的速度和更低的功耗执行单一任务需求的提升,过去的通用处理器的瓶颈凸显,专用AI芯片开始爆发。这个趋势不仅吸引了谷歌,亚马逊和苹果等公司的投身其中,还有几十家初创企业大举进入。

对新芯片设计和硬件架构的关注表明,我们需要在基本计算方面取得根本性突破,以防止今天的AI成为死胡同。

LeCun先生说,在人工智能的整个历史中,在研究人员在该领域提出突破性见解之前,硬件方面通常已经取得了很大的进步。

“在相当长的一段时间里,人们没有太多想法”,他说。

以反向传播(back propagation)为例,这是当今深度学习系统中的一项核心技术,它将算法在其计算之上进行重新计算,以最大限度地减少错误。LeCun先生表示,这是早期研究的一个明显延伸,但在计算硬件发展之后,才在20世纪90年代得到广泛应用。

Facebook过去曾设计过其他类型的硬件,例如为数据中心设备提出新想法,然后再开放供其他人使用。LeCun先生说,同样的方法将应用于芯片设计,并补充道:“目的是将其送走。”(The objective is to give it away)。

该公司还将研究重点放在神经网络的新设计上,神经网络是图像和语言识别等最新进展背后的深度学习系统的核心。

三十年前,LeCun先生在AT&T贝尔实验室的AI芯片上工作时,建立了第一个“卷积”神经网络:一种基于视觉皮层在动物中如何工作的设计,现在在深度学习系统中很常见。

今天的神经网络使用一种称为监督学习的技术,这需要大量的数据进行训练,在像Facebook这样规模的公司中,这种运算消耗大量的电力。

Facebook现在已经对每天上传到其核心服务上的所有2-3亿张照片进行了大量即时分析,包括使用面部识别来识别其中的人物,创建描述场景的标题,以及识别裸露等。

LeCun先生表示,Facebook正在做我们可以做的任何事情来降低功耗[并]改善延迟,以加快处理速度。但他补充说,在网站上实时监控视频所带来的巨大需求需要新的神经网络设计。

Facebook也在寻求新的神经网络架构,以模仿人类智能的更多方面,并使其系统更自然地与之交互。

LeCun先生表示,公司正在大力投资“自我监督”系统,这些系统能够对周围的世界做出更广泛的预测,而不仅仅是能够得出与他们接受过培训的数据直接相关的结论。

这可以使他们对世界产生同样广泛的理解,使人类能够应对新情况。

“就新用途而言,Facebook会感兴趣的一件事是提供具有一定程度常识的智能数字助理 ”,LeCun说。“他们有背景知识,你可以就任何话题与他们进行讨论。”

计算机具有常识的想法还处于早期阶段,LeCun先生表示,这种更深层次的人工智能短期内不会发生。

“你如果想机器像人类或动物那样能够就当前发生的事情预测可能的结果,这还有很长的路要走 ”,LeCUN说。“能够预测不确定性是当今的主要挑战之一。”

Facebook是尝试增强当今神经网络的更广泛研究工作的一部分。LeCun先生将于周一在旧金山举行的Chip会议上发表演讲,概述这项工作。研究工作包括将计算机存储器添加到神经网络中,以便他们在与人进行“对话”时可以保留更多信息并形成更强的上下文感。

神经网络如何发挥作用的进展很可能对为其芯片设计产生连锁反应,这可能会为制造当今领先的AI芯片的公司带来更多的竞争。

LeCun先生说,谷歌的TPU已经成为最强大的机器学习数据中心芯片,但他们做出的假设不一定适用于未来的神经网络架构。

另一方面,芯片的灵活性可能具有其他缺点。例如,微软计划在其所有数据中心服务器中加入一种不同类型的芯片,称为现场可编程门阵列(FPGA)。它们在如何使用它们方面更加灵活,但在处理大量数据方面效率较低,使它们对于针对特定任务进行了优化的芯片处于劣势。